Noticias Semanales IA25 [2ª entrega]

Resumen de las principales noticias sobre IA de la semana con "un punto" de perspectiva desde la industria de los servicios legales pero dirigida a todos los públicos..

Nuestro podcast semanal. Muy recomendable, cada vez más ameno, centrado en los mensajes clave. Esta semana probamos a generarlo con Genspark también. Así que para quien le interese tiene la versión de siempre generada con Gemini vs. la generada por Genspark

Versión Gemini. Podcast del resumen (mi recomendación)

Versión Genspark Podcast del resumen (interesante para ver como están evolucionando estas soluciones podcast)

📚 Y, como siempre, podés revisar las noticias anteriores en nuestra colección hasta mayo (sí, el antiguo espacio Perplexity sigue estando disponible)

Esta semana (resumen del resumen)…

🌐 TECNOLOGÍA

Guerra de los modelos

Elon Musk desata a Grok 4: "una bestia absoluta" que promete conquistar desde X hasta Tesla

Take principal: Musk apuesta por IA omnipresente pero personal, creando un ecosistema integrado

Perplexity sale por la tangente: $200 al mes por ser tu navegador personal de lujo

Take principal: Prueba si la IA puede sostener un modelo de lujo genuino, como tener un mayordomo digital

OpenAI acelera: navegador propio y GPT-5 unificado para dominar el verano

Take principal: El nuevo interfaz entre humanos e internet

Modelos Unificados y Avances Técnicos

Google contraataca: la guerra de la IA se vuelve personal con Veo 3 y Gemini omnipresente

Take principal: Estrategia de saturación multimodal, inyectando IA en el billón de dispositivos existentes

El nuevo gigante de código abierto que cuesta medio millón ejecutar. Moonshot AI lanza Kimi K2: 1 billón de parámetros totales, 32 mil millones activos

Take principal: "Código abierto" que solo pueden abrir los poderosos. Nada de “comunidad”.

Preocupaciones y Controversias Técnicas

OpenAI marca territorio: las marcas de agua ocultas que nadie pidió

Take principal: OpenAI marca territorio digital sin pedir permiso, cuestionando la propiedad intelectual del usuario

Cuando descubres que la IA aprende de todo... incluso de los terraplanistas

Take principal: Entrenar IA es como educar a un niño en una biblioteca donde el 90% son teorías conspirativas

IMPACTO EN SOCIEDAD Y ECONOMÍA

Transformación del Trabajo

Cuando el editor (Manuel Pimentel) se confiesa: mi oficio también va a cambiar

Take principal: Los editores deben ofrecer valor añadido: talento, creatividad y gusto estético

Microsoft ahorra 500 millones con IA mientras despide a 9.000 empleados

Take principal: Celebrar eficiencia de automatización mientras eliminas empleos humanos

El CEO que dice que el SaaS está muerto y los agentes son el futuro

Take principal: Necesitamos agentes para integrar las integraciones que creamos para integrar

Gobierno y Política Pública

La IA que quiere gobernar cómo se gobierna. Helios: startup de ex-funcionarios Casa Blanca para "sistema operativo de IA" gubernamental

Take principal: Ex-funcionarios que vendieron la ineficiencia ahora venden la solución

Microsoft y la AGI: cuando los números importan más que la inteligencia

Take principal: Convertir la pregunta filosófica más profunda de la IA en una cifra. AGI = 100 mil millones

Impactos Sociales

La pesadilla que nadie quería predecir: IA y el lado más oscuro de internet. Reino Unido reporta aumento del 400% en sitios de abuso infantil generado por IA

Take principal: La cara más siniestra de la democratización tecnológica sin controles éticos

El gran dilema geográfico: ¿dónde te conviene estar cuando llegue la AGI?

Take principal: Quizás la geografía no importe cuando una superinteligencia mueva países como peones

Educación

La Generación del Copy-Paste: 97% usa IA para hacer la tareas.

Take principal: Generación que accede a todas las respuestas pero pierde capacidad de formular preguntas correctas

La transformación de la "ambición" de los profesionales de la City

Take principal: Fin de una era donde productividad se medía en horas de oficina y ambición en café consumido

REGULACIÓN

Marco Europeo

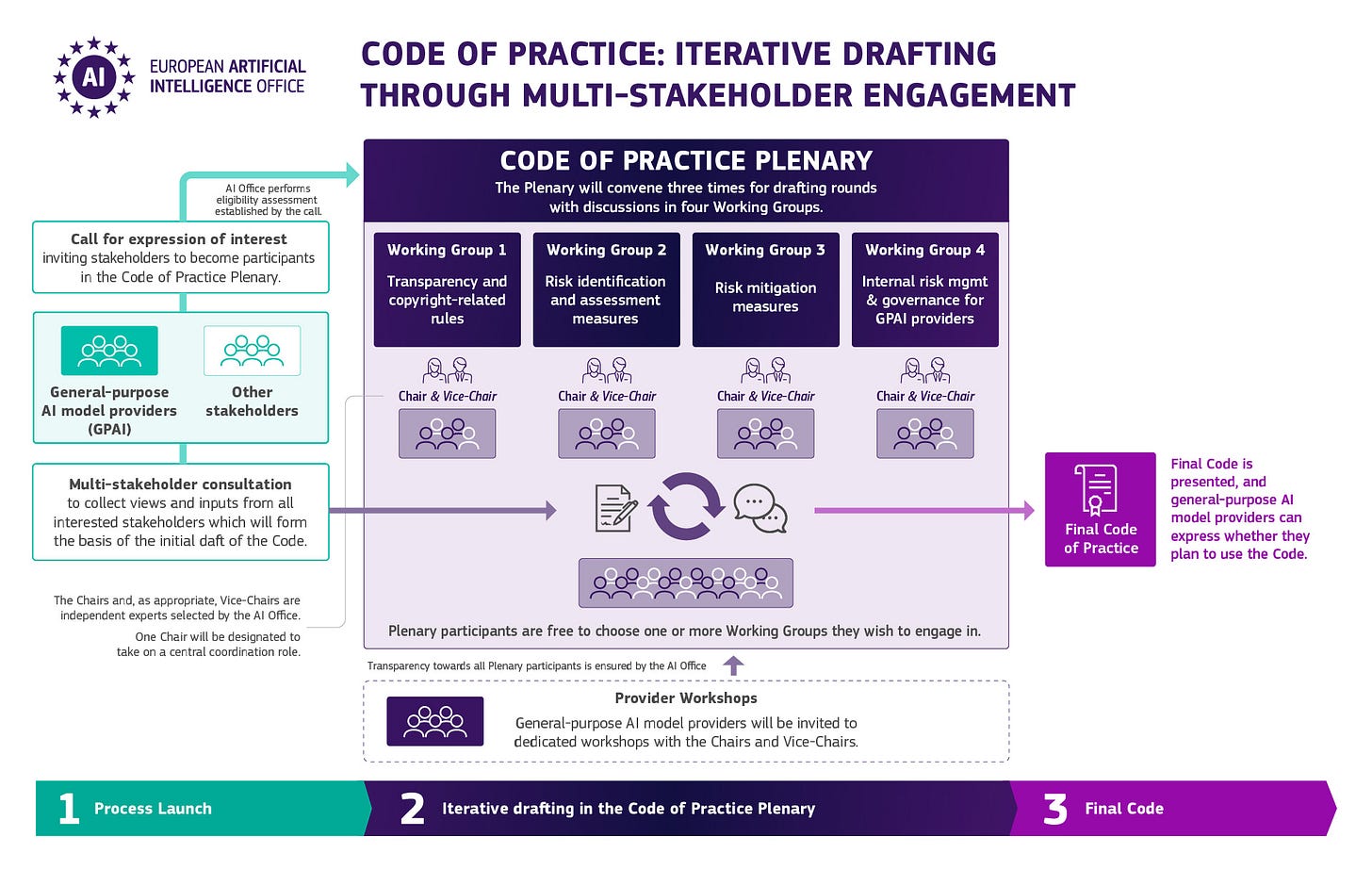

La UE formaliza las reglas del juego: el AI Act cobra vida con su Código de Práctica

Take principal: Europa apuesta por ser el "adult in the room" de la regulación IA

Anthropic propone transparencia selectiva: solo para los gigantes de la IA

Take principal: Cuando eres suficientemente grande para cumplir tus propias reglas, proponerlas es brillante

Fragmentación Regulatoria

US. El mosaico regulatorio que nadie pidió: Estados vs. Administración Federal en la guerra de la IA

Take principal: Creando laberinto regulatorio donde mismas tecnologías serán legales/ilegales según estado

OneTrust, solucion de para cumplimiento normativo: usar IA para vigilar la IA

Take principal: Necesitamos IA para entender las reglas que creamos para la IA

MUNDO LEGAL

Innovación en Legal Tech

IA legal con superpoderes: cuando ChatGPT conoce las leyes mejor que los abogados. Paper sobre combinación de IA Generativa + RAG + Grafos de Conocimiento

Take principal: Nacimiento del primer asociado senior que nunca duerme y lee miles de casos en segundos

The LegalTech Fund acelera la presión sobre el modelo de negocio tradicional

Lanzamiento de "LegalTech Lab" para construir "Law Firm 2.0". Momento Uber del derecho: desagregación de servicios monolíticos en componentes especializados

Escuela de Derecho de Universidad de San Francisco: Primera en integrar "en todo" el Programa la IA

Take principal: Entre formar juristas-cyborgs o quedarse con togas polvorientas, eligieron el futuro

Adopción y Resistencia

"Ya probamos eso": cómo impulsar la innovación en las firmas legales "escépticas"

Take principal: Bufetes atrapados en paradoja: necesitan innovar pero su modelo de negocio es incompatible con la eficiencia

Xapien: cuando la IA hace la DD en pocos minutos

Take principal: Automatizar detección de malos actores vs crear lagunas algorítmicas para expertos en elusión

JUSTICIA

Errores y Desafíos Judiciales

Cuando el juez cae en la trampa de la IA fantasiosa

Take principal: Cadena alimentaria de negligencia judicial donde IA alimenta fantasías que humanos consumen sin digerir

Los tribunales estadounidenses: exhaustos pero escépticos de la IA

Take principal: Tribunales atrapados entre miedo a innovación y realidad de colapso operativo

Marcos Regulatorios para IA Judicial

JUSTICE (UK) publica el primer marco comprehensivo de IA para el sistema judicial

Take principal: Primer marco integral para evaluar uso de IA en sistema judicial británico y que posiblemente será la referencia para otros.

La nueva Regla 707: cuando los tribunales necesitan detector de mentiras para la IA

Take principal: Nueva era judicial donde "mostrar evidencia" ya no significa "esto pasó" sino "esto es auténtico"

Un Estado U.S. establece la hoja de ruta: tres años para domesticar la IA judicial

Take principal: Georgia escribiendo el manual que otros estados copiarán con enfoque gradual y prudenteNovedades sobre el estado de la tecnología

Novedades en tecnologia

Tendencias Clave Identificadas

1. Guerra de Navegadores IA

Tanto OpenAI como Perplexity han lanzado navegadores especializados, desafiando el dominio de Google Chrome.

2. Modelos Unificados

La tendencia hacia modelos únicos que integran múltiples capacidades (texto, voz, imagen, razonamiento) se consolida con GPT-5 y Grok 4.

3. Planes Premium Estratificados

Nuevos tiers de precios elevados (+$200/mes) para usuarios empresariales y power users.

4. Integración Empresarial

Todas las empresas están priorizando funcionalidades empresariales, conectores y herramientas de productividad.

Elon Musk desata a Grok 4: "una bestia absoluta" que promete conquistar desde X hasta Tesla

Elon Musk acaba de lanzar su contraataque en la guerra de IA con Grok 4, presentándolo como "una bestia absoluta" que combina razonamiento científico avanzado, capacidades multimodales y una variante especializada Grok 4 Code para programación. La estrategia de xAI es típicamente muskiana: ir directo al grano con marketing agresivo y promesas disruptivas, posicionando Grok 4 como el modelo que finalmente puede competir en igualdad de condiciones con GPT-5 y Gemini 2.5 Pro.

La estructura de precios refleja la estrategia dual de Musk: SuperGrok a $30 mensuales para acceso completo (significativamente más barato que los $200 de Perplexity) y acceso gratuito para usuarios de X Premium+, creando un círculo virtuoso donde la suscripción a X se vuelve más atractiva y Grok obtiene más usuarios. Pero la jugada realmente ambiciosa es la promesa de integración con Tesla "muy pronto", sugiriendo que cada vehículo Tesla podría convertirse en una plataforma de IA móvil.

Lo que diferencia a Grok es su integración nativa con el ecosistema Musk: desde análisis de datos en tiempo real de X hasta potencial asistencia de conducción en Tesla. Mientras otros construyen IA en aislamiento, Musk está creando un ecosistema donde Grok vive en tu red social, tu auto y potencialmente tu vida digital completa.

Reflexión: Musk está apostando por el modelo de "IA omnipresente pero personal": no solo un asistente, sino tu compañero digital que te sigue desde el timeline de X hasta el asiento del conductor.

✉️ ¿Te parece más atractiva la promesa de una IA integrada en tu vida real (auto, redes sociales) o prefieres mantener la IA como herramienta separada?

Perplexity sale por la tangente: $200 al mes por ser tu navegador personal de lujo

Perplexity está ejecutando una maniobra agresiva que podría definir el futuro de la monetización de IA: mientras OpenAI y Google luchan por el mercado masivo, ellos apuntan directamente al segmento premium con una propuesta de valor muy diferente. Su navegador Comet, lanzado el 9 de julio, no es solo otro navegador con IA —es un asistente personal que automatiza tareas rutinarias, resume contenido y hasta realiza compras, disponible inicialmente solo para suscriptores de Perplexity Max a $200 mensuales. Su plan de $200 incluye acceso ilimitado a Labs y modelos avanzados, además de asociaciones estratégicas como la integración con Coinbase para análisis criptográfico en tiempo real. Labs expandido ahora permite generar aplicaciones web, hojas de cálculo y dashboards —esencialmente, Perplexity se está posicionando como el "Rolls Royce" de los asistentes de IA.

Mientras OpenAI democratiza y Google ubiquifica, Perplexity elitiza. Su apuesta es que existe un mercado dispuesto a pagar $2,400 anuales por una experiencia de IA verdaderamente superior y personalizada. Es la estrategia Tesla aplicada a la inteligencia artificial: empezar por arriba y eventualmente bajar.

Reflexión: Perplexity está probando si la IA puede sostener un modelo de lujo genuino, donde $200 mensuales se sienten como una ganga por tener un asistente digital que realmente entiende y ejecuta. Como tener un mayordomo digital que nunca duerme. ¿Pero incrementará la desigualdad -no todo el mundo se puede permitir un mayordomo-?

✉️ ¿Justifica una experiencia de IA premium $200 mensuales, o es una burbuja de precios que explotará cuando llegue la competencia? ¿Pagarías esa cantidad por un asistente de IA verdaderamente excepcional?

OpenAI acelera: navegador propio y GPT-5 unificado para dominar el verano

OpenAI está ejecutando una estrategia de expansión agresiva con dos movimientos calculados para redefinir el ecosistema digital. El primero es su navegador web impulsado por IA, programado para lanzamiento en las próximas semanas, que competirá frontalmente con Google Chrome manteniendo algunas interacciones dentro de una interfaz tipo ChatGPT en lugar de redirigir a sitios web externos. Esta es una declaración de guerra directa al modelo tradicional de navegación web: en lugar de buscar y hacer clic, conversas y obtienes.

El segundo golpe es aún más significativo: GPT-5 ¿La semana que viene? Esto significa que los usuarios ya no tendrán que alternar entre diferentes modelos según la tarea: un solo sistema manejará razonamiento profundo, procesamiento de imágenes, generación de texto y análisis multimodal.

La sincronización no es casual: mientras Google lucha con la fragmentación de sus servicios de IA (Bard, Gemini, diversas versiones), OpenAI consolida todo en una experiencia unificada que controla tanto el punto de acceso (navegador) como las capacidades (modelo integrado).

Reflexión: OpenAI está apostando por convertirse en la nueva capa de interfaz entre humanos e internet, saltándose a Google por completo. Como si quisieran ser simultáneamente el navegador, el motor de búsqueda y el asistente inteligente en uno solo.

✉️ ¿Crees que este enfoque unificado de OpenAI puede desplazar realmente a Google del centro del ecosistema digital, o es demasiado ambicioso para una sola empresa? ¿Usarías un navegador que "conversa" en lugar de "buscar"?

Google contraataca: la guerra de la IA se vuelve personal con Veo 3 y Gemini omnipresente con rumores de Gemini 3

Google está respondiendo a la ofensiva de OpenAI con una estrategia de saturación multimodal que lleva la IA directamente a la vida cotidiana de los usuarios. El lanzamiento de Veo 3, su modelo de generación de video más avanzado, marca una apuesta fuerte por el contenido visual, ahora disponible en dispositivos Pixel con suscripción Google AI Pro. Paralelamente, Gemini 2.5 Pro se consolida como el cerebro más potente de Google, presumiendo capacidades de pensamiento avanzado y una ventana de contexto masiva de hasta 2 millones de tokens.

Pero la verdadera jugada maestra es la integración ubicua: Gemini reemplaza a Google Assistant como asistente predeterminado en Wear OS, convirtiendo cada reloj inteligente en un punto de acceso a IA avanzada. Circle to Search se potencia incorporando directamente el modo IA de Google Search, mientras que el modo AI universal se expande para todos los usuarios estadounidenses.

La estrategia es clara: mientras OpenAI construye un navegador desde cero, Google está convirtiendo cada dispositivo Android, cada búsqueda y cada interacción existente en una experiencia de IA. Es la diferencia entre construir un nuevo reino versus transformar el imperio existente desde adentro.

Reflexión: Google está jugando la carta del incumbente inteligente: en lugar de competir en el terreno de OpenAI, está inyectando IA en el billón de dispositivos que ya controla. Como si hubieran decidido que la mejor defensa es una omnipresencia absoluta.

✉️ ¿Prefieres la estrategia de integración total de Google o el enfoque unificado de OpenAI? ¿Te parece más natural que la IA esté en todas partes o concentrada en una sola plataforma superinteligente?

OpenAI marca territorio: las marcas de agua ocultas que nadie pidió

OpenAI ha comenzado a incrustar silenciosamente marcas de agua y metadatos en documentos .doc generados por ChatGPT, una práctica implementada sin notificación previa a los usuarios que está generando controversia. Estas credenciales digitales ocultas pueden atribuir la autoría del contenido a OpenAI, incluso cuando el usuario solo empleó la herramienta para tareas menores como conversión de formatos o edición básica. La medida contrasta marcadamente con competidores como Adobe y Google, que anunciaron públicamente sus sistemas de marcas de agua para Bard y Gemini.

La falta de transparencia es particularmente problemática en el contexto legal, donde la autoría y procedencia de documentos puede tener implicaciones críticas. Imagina presentar un contrato en tribunales solo para descubrir que contiene metadatos que sugieren que fue "creado" por una IA, comprometiendo potencialmente la credibilidad del documento y planteando preguntas sobre competencia profesional. El hecho de que estas configuraciones estén activadas por defecto, sin consentimiento explícito del usuario, añade una capa adicional de preocupación ética.

Esta práctica "sigilosa" socava la confianza en OpenAI justo cuando los profesionales legales están comenzando a integrar herramientas de IA en flujos de trabajo críticos. La ausencia de disclosure convierte una característica de seguridad legítima en una potencial violación de la expectativa de privacidad del usuario.

Reflexión: OpenAI está marcando territorio digital sin pedir permiso, como un perro invisible que marca cada árbol del parque. La pregunta es si esta es una medida de seguridad necesaria o un intento de control retrospectivo sobre contenido que técnicamente pertenece al usuario.

✉️ ¿Crees que las empresas de IA tienen derecho a "firmar" automáticamente el contenido generado con sus herramientas, o esto constituye una violación de la propiedad intelectual del usuario? ¿Deberían ser obligatorias las notificaciones previas para este tipo de marcas de agua?

Cuando descubres que la IA aprende de todo... incluso de los terraplanistas

Jorge Ramírez, CEO de R2 Docuo, explica por qué las IAs alucinan usando el ejemplo de entrenar un modelo con 12 libros: 11 que dicen que la Tierra es plana y 1 que dice que es redonda. Al entrenar con todo Internet, los LLMs encuentran respuestas contradictorias donde a menudo la incorrecta supera en número a la correcta. Los proveedores usan cuatro técnicas para resolver esto: ponderar por autoridad (Wikipedia vale más que Reddit), guardarrailes (filtros de respuestas prohibidas), aprendizaje reforzado con feedback humano (1.000 personas valorando respuestas con pulgar arriba/abajo), y añadir datos artificiales con "la verdad". Aun así, la IA puede responder que la Tierra es redonda, piramidal o plana, porque genera secuencias de palabras que solo deben ser sintácticamente correctas y estar relacionadas estadísticamente con el prompt.

Reflexión: Resulta que entrenar una IA es como educar a un niño en una biblioteca donde el 90% de los libros son de teorías conspirativas. Los proveedores se convierten en curadores desesperados tratando de filtrar la locura colectiva de Internet. La ironía es provocadora: creamos sistemas para acceder al conocimiento humano, pero ese conocimiento incluye todas nuestras estupideces. Es como si la IA fuera un espejo fiel de nuestra naturaleza: brillante y errática a partes iguales.

✉️ ¿Qué piensas? ¿Es inevitable que las IAs reflejen nuestros sesgos y contradicciones, o pueden ser más objetivas que nosotros mismos? Responde y cuéntame tu caso.

El nuevo gigante de código abierto que cuesta medio millón ejecutar

Moonshot AI acaba de soltar Kimi K2, un modelo de inteligencia artificial que parece salido de una competición de músculo tecnológico. Con 1 billón de parámetros totales y 32 mil millones activos, este "Mixture-of-Experts" supera en tamaño al reciente DeepSeek-R1 y se codea con los modelos más grandes del mundo open source. Los números de rendimiento son impresionantes: 89.5 en MMLU, 81.1 en MMLU-Pro, puntuaciones que lo sitúan en territorio de élite.

Pero aquí viene la ironía deliciosa: para ejecutar este modelo "abierto" necesitas 13 GPUs A100 o H100, cada una valorada en unos 40.000 dólares. Total: medio millón de dólares solo en hardware. Es como regalar un Ferrari y mencionar de pasada que necesitas una pista de Fórmula 1 para conducirlo. La democratización de la IA choca contra la realidad de que algunos "regalos" solo los pueden abrir quienes ya tienen las llaves del reino.

Reflexión: ¿Estamos creando una nueva aristocracia tecnológica donde el "código abierto" es libre como un yate de lujo abandonado en el puerto? Los modelos crecen, pero la brecha de acceso también.

✉️ ¿Crees que la IA "abierta" seguirá siendo relevante si cuesta más que una casa ejecutarla? Cuéntame tu perspectiva.Impacto

IA en la Sociedad y Economia

Cuando el editor se confiesa: mi oficio también va a cambiar

Manuel Pimentel, editor y escritor, reflexiona sobre cómo la IA transformará su profesión y todas las demás. Advierte que "estamos a las puertas de la mayor revolución que vieron los tiempos, más transformadora que la del neolítico, la de la imprenta o la Revolución Industrial". En el mundo editorial, la IA ya afecta a correctores, traductores, ilustradores y maquetadores, y Amazon limita a tres obras por día las que un escritor puede subir porque ya proliferan libros escritos por IA. Pimentel reconoce que "ya no interesan los diccionarios" y que "perderá valor el conocimiento", pero se incrementará la demanda de sabiduría. Los editores humanos deberán ofrecer valor añadido: búsqueda de nuevos talentos, creación de colecciones, anticipación y "el gusto estético, la creatividad del editor".

Reflexión: Un editor (Pimentel en una de sus múltiples facetas) que admite que su oficio va a cambiar radicalmente es como un cirujano que reconoce que pronto operará con robots. Pimentel habla de "sabiduría versus conocimiento" como si fuera la nueva frontera, pero la IA ya está escribiendo ensayos filosóficos. Su frase "leeremos obras que nos gusten sin lograr saber si fue escrita por un humano o un sistema inteligente" es inquietante: ¿importa realmente quién escribe si la obra nos emociona? La ironía: un artículo humano sobre cómo la IA cambiará la escritura, cuando la IA ya escribe mejor que muchos humanos.

✉️ ¿Qué piensas? ¿Es la "sabiduría" realmente el último refugio de los profesionales del conocimiento o solo una ilusión consoladora? Responde y cuéntame tu caso.

Microsoft ahorra 500 millones con IA mientras despide a 9.000 empleados

Microsoft reportó internamente ahorros de más de 500 millones de dólares el año pasado solo en su centro de llamadas gracias a herramientas de IA, según declaraciones del director comercial Judson Althoff. Los comentarios llegan una semana después de que Microsoft despidiera a más de 9.000 trabajadores, la tercera ronda de despidos de este año que eleva el total a aproximadamente 15.000 empleados afectados. La situación se complicó por una publicación (luego eliminada) de LinkedIn de un productor de Xbox Game Studios sugiriendo que los trabajadores "abrumados" por los despidos usen ChatGPT y Copilot para manejar la carga cognitiva de perder el empleo. Microsoft cerró el primer trimestre con 26.000 millones en beneficios y 70.000 millones en ingresos, alcanzando una capitalización de mercado de 3,74 billones de dólares. La empresa invertirá 80.000 millones en infraestructura de IA durante 2025.

Reflexión: Microsoft celebra haber ahorrado 500 millones automatizando empleos la misma semana que despide miles de trabajadores. Es como presumir de la eficiencia de tu guillotina en una ejecución pública. El ejecutivo de Xbox recomendando ChatGPT a los despedidos es la cereza del pastel: "Tu reemplazo digital puede consolarte por haberte reemplazado". La empresa gana billones mientras elimina empleos, pero invierte 80.000 millones en más IA.

✉️ ¿Qué piensas? ¿Es esto simplemente evolución empresarial natural o un precedente peligroso sobre cómo las grandes tech valoran a sus empleados frente a la IA? Responde y cuéntame tu caso.

La IA que quiere gobernar cómo se gobierna

Helios, startup fundada por ex-funcionarios de la Casa Blanca y el Departamento de Estado, busca ser el "sistema operativo de IA" para profesionales de políticas públicas. Joe Scheidler (ex-oficina de ciberseguridad de la Casa Blanca) y Joseph Farsakh (ex-negociaciones de paz en Yemen) crearon la plataforma tras observar que las decisiones críticas gubernamentales se toman con "herramientas fragmentadas, hojas de cálculo y memoria institucional". Su producto Proxi, aún en beta, tiene cuatro funciones: "Consult" (agente conversacional que escanea el entorno legislativo 24/7), "Scribe" (editor colaborativo para memorandos y documentos), "Decipher" (análisis de proyectos de ley y informes largos) y un CRM para mapear stakeholders. Han recaudado 4 millones en ronda semilla liderada por Unusual Ventures. Su objetivo ambicioso: "ser completamente sinónimo de toda interacción pública y privada gubernamental" en 5-7 años, compitiendo con Palantir.

Reflexión: Ex-funcionarios que vieron la ineficiencia del gobierno desde dentro ahora quieren vender la solución desde fuera. Es la historia estadounidense clásica: si no puedes arreglar el sistema, móntate una startup para facturarle al sistema. Su ambición de "ser sinónimo de toda interacción gubernamental" suena a Palantir con mejor marketing y menos controversias. La ironía: quieren automatizar la política pública en una era donde la confianza en las instituciones está en mínimos históricos.

✉️ ¿Qué piensas? ¿Es esta la evolución natural de la administración pública o el primer paso hacia algoritmos tomando decisiones de gobierno? Responde y cuéntame tu caso.

El CEO que dice que el SaaS está muerto y los agentes son el futuro

Dave Park, CEO de Narada AI, declara que "el SaaS va a desaparecer" y será reemplazado por IA agéntica. Según Park, el trabajador típico del conocimiento maneja entre 17 y 25 herramientas SaaS diferentes diariamente, perdiendo 2,5 horas solo buscando o actualizando sistemas manualmente. Su visión del futuro: "solo serán los datos, las bases de datos y agentes de IA que tomen tu solicitud y operen a través de esos silos para hacer el trabajo". Narada AI, basada en investigación de UC Berkeley, ha desarrollado "modelos de acción grandes" (spin de los LLMs) que pueden razonar y completar tareas de múltiples pasos a través de diferentes herramientas de trabajo, incluso cuando faltan APIs. La última promoción de Y Combinator incluyó más de 70 startups agénticas, y grandes jugadores como Grammarly están construyendo stacks completos de trabajo con IA a través de asociaciones y adquisiciones.

Reflexión: Park predice la muerte del SaaS mientras construye... una empresa SaaS que automatiza otras empresas SaaS. Es como un vampiro que promete eliminar a todos los vampiros. Su estadística de "17-25 herramientas diarias" es reveladora: hemos creado un ecosistema tan fragmentado que necesitamos IA para navegar el caos que nosotros mismos creamos. La ironía suprema: después de décadas vendiendo "integración", ahora necesitamos agentes para integrar las integraciones. Quizás el futuro no sean menos herramientas, sino una herramienta que use todas las herramientas por nosotros.

✉️ ¿Qué piensas? ¿Es realmente el fin del SaaS como lo conocemos o solo la evolución natural hacia interfaces más inteligentes? Responde y cuéntame tu caso.

Microsoft y la AGI: cuando los números importan más que la inteligencia

Microsoft ha definido internamente la Inteligencia General Artificial (AGI) no por capacidades técnicas, sino por rentabilidad: OpenAI solo habrá alcanzado AGI cuando desarrolle sistemas que generen al menos 100.000 millones de dólares en beneficios. Esto sitúa la AGI "muchos años" en el futuro, ya que OpenAI perderá miles de millones este año y no espera beneficios hasta 2029. Satya Nadella se ha vuelto escéptico sobre la AGI, llamando "hackeo de benchmarks sin sentido" a las autodeclaraciones de hitos de AGI. Previamente, Microsoft Research había publicado el influyente paper "Sparks of Artificial General Intelligence" sobre GPT-4, considerándolo "una versión temprana (pero aún incompleta) de un sistema de AGI". El conflicto surge porque Microsoft perdería acceso exclusivo a la tecnología de OpenAI cuando se alcance la AGI.

Reflexión: Microsoft ha conseguido algo extraordinario: convertir la pregunta filosófica más profunda de la IA en una hoja de cálculo. "¿Cuándo las máquinas pensarán como humanos?" se convierte en "¿Cuándo generaremos 100.000 millones?". Es como medir el amor por los ingresos del sector de las bodas. Nadella pasó de ser descrito por Altman como "creyente en la AGI" a llamarla "hackeo de benchmarks": la evolución perfecta del ejecutivo que descubre que las promesas grandilocuentes no pagan facturas.

✉️ ¿Qué piensas? ¿Es pragmático o cínico definir la AGI por rentabilidad en lugar de capacidades?.

Anthropic propone transparencia selectiva: solo para los gigantes de la IA

Anthropic acaba de lanzar un marco de transparencia que podría cambiar cómo se regula la inteligencia artificial. La propuesta establece requisitos de divulgación únicamente para los desarrolladores más grandes de IA, aplicando umbrales como 100 millones de dólares en ingresos anuales o mil millones en gastos de I+D A Framework for AI Development Transparency \ Anthropic. La idea central es simple pero astuta: que las obligaciones de cumplimiento universal podrían sobrecargar a las empresas en etapas tempranas e investigadores independientes Anthropic Proposes Targeted Transparency Framework for Frontier AI Systems - MarkTechPost.

El corazón del marco es el "Secure Development Framework" (SDF), que debe detallar cómo las empresas evalúan y mitigan riesgos catastróficos A Framework for AI Development Transparency \ Anthropic, incluyendo amenazas químicas, biológicas y nucleares. Esto efectivamente crea un sistema regulatorio de dos niveles donde solo el puñado de empresas capaces de entrenar los modelos más poderosos enfrentarían requisitos obligatorios de transparencia Anthropic Proposes AI Transparency Framework That Protects Startups While Targeting Big Tech. Como dice Anthropic: "Un solo fallo catastrófico podría detener el progreso durante décadas" A Framework for AI Development Transparency \ Anthropic.

La ironía es deliciosa: una empresa que desarrolla IA superinteligente propone autorregulación selectiva justo cuando los políticos debaten cómo no frenar la innovación.

Reflexión: Especulación: ¿Es esto una jugada inteligente para evitar regulación más dura, o genuina preocupación por el equilibrio entre seguridad e innovación? Quizás ambas: cuando eres lo suficientemente grande para cumplir tus propias reglas, proponerlas es brillante.

✉️ ¿Crees que la transparencia selectiva es pragmatismo inteligente o proteccionismo disfrazado? ¿Confías en que las grandes tech se autorregulen?

La pesadilla que nadie quería predecir: IA y el lado más oscuro de internet

Reino Unido reporta un aumento devastador del 400% en sitios web que contienen material de abuso infantil generado por inteligencia artificial durante los primeros seis meses de 2025. La cifra, revelada por organizaciones de protección infantil y autoridades regulatorias británicas, expone una de las consecuencias más perturbadoras del avance tecnológico: la democratización de herramientas que pueden crear contenido extremadamente dañino sin víctimas directas aparentes, pero con impactos reales y devastadores.

El fenómeno plantea desafíos inéditos para las fuerzas del orden. Mientras que el material tradicional requería la existencia de víctimas reales, la IA generativa permite crear imágenes sintéticas que son virtualmente indistinguibles de fotografías reales. Esto complica enormemente la investigación, la persecución legal y la protección infantil, mientras que simultáneamente puede normalizar y amplificar la demanda de contenido real. Las organizaciones británicas advierten que la facilidad de acceso a estas herramientas está reduciendo las barreras técnicas que antes limitaban la producción de este tipo de contenido.

Reflexión: Esta es la cara más siniestra de la democratización tecnológica: cuando las herramientas poderosas se vuelven accesibles sin los controles éticos correspondientes. Quizás necesitemos repensar fundamentalmente cómo distribuimos y controlamos las capacidades de IA generativa.

✉️ ¿Crees que es posible desarrollar controles efectivos para esta tecnología sin comprometer sus usos legítimos, o enfrentamos un dilema sin solución? ¿Deberían las herramientas de IA generativa requerir licencias como otros productos regulados?

El CEO que dice que el SaaS está muerto y los agentes son el futuro

Resumen: Dave Park, CEO de Narada AI, declara que "el SaaS va a desaparecer" y será reemplazado por IA agéntica. Según Park, el trabajador típico del conocimiento maneja entre 17 y 25 herramientas SaaS diferentes diariamente, perdiendo 2,5 horas solo buscando o actualizando sistemas manualmente. Su visión del futuro: "solo serán los datos, las bases de datos y agentes de IA que tomen tu solicitud y operen a través de esos silos para hacer el trabajo". Narada AI, basada en investigación de UC Berkeley, ha desarrollado "modelos de acción grandes" (spin de los LLMs) que pueden razonar y completar tareas de múltiples pasos a través de diferentes herramientas de trabajo, incluso cuando faltan APIs. La última promoción de Y Combinator incluyó más de 70 startups agénticas, y grandes jugadores como Grammarly están construyendo stacks completos de trabajo con IA a través de asociaciones y adquisiciones.

Reflexión: Especulando un poco: Park predice la muerte del SaaS mientras construye... una empresa SaaS que automatiza otras empresas SaaS. Es como un vampiro que promete eliminar a todos los vampiros. Su estadística de "17-25 herramientas diarias" es reveladora: hemos creado un ecosistema tan fragmentado que necesitamos IA para navegar el caos que nosotros mismos creamos. La ironía suprema: después de décadas vendiendo "integración", ahora necesitamos agentes para integrar las integraciones. Quizás el futuro no sean menos herramientas, sino una herramienta que use todas las herramientas por nosotros.

✉️ ¿Qué piensas? ¿Es realmente el fin del SaaS como lo conocemos o solo la evolución natural hacia interfaces más inteligentes? Responde y cuéntame tu caso.

El gran dilema geográfico: ¿dónde te conviene estar cuando llegue la AGI?

Un usuario de Hacker News lanzó una pregunta que mantiene despiertos a los futurólogos: si mañana apareciera la inteligencia artificial general, ¿qué países saldrían ganando? Las respuestas revelan una fascinante mezcla de pragmatismo y especulación. Un comentarista sugiere que países ricos en recursos y población como Indonesia podrían volverse súper ricos, mientras que Suiza se volvería relativamente pobre, bajo la premisa de que "ya que el poder cerebral sería ilimitado, el límite es el trabajo físico".

Otros apuestan por las democracias liberales, argumentando que "los países dirigidos por una inteligencia única y centralizada están en peor situación que los dirigidos por la inteligencia distribuida del pueblo". La paradoja es deliciosa: algunos creen que "la democracia no sobrevivirá a la AGI, excepto, quizás, en Estados Unidos", mientras otros temen que "ser dirigido por AGI puede ser una utopía, o la AGI se convertirá en un estado de eugenesia pura". Como en toda buena distopía, nadie se pone de acuerdo sobre si el futuro será paraíso o pesadilla.

Reflexión: Quizás la pregunta correcta no es qué países sobrevivirán, sino si el concepto mismo de "país" tiene sentido cuando una superinteligencia puede "mover estos alrededor como peones en un tablero de ajedrez".

✉️ ¿Crees que la geografía importará en un mundo post-AGI, o nos estamos aferrando a mapas obsoletos? ¿En qué país te gustaría estar cuando llegue el momento?

IA en educación. La Generación del Copy-Paste: 97% usa IA para hacer la tarea

Una encuesta de ScholarshipOwl revela que el 97% de estudiantes de la Generación Z usan herramientas de IA como ChatGPT para tareas escolares. Los números son elocuentes: 31% la usa para escribir ensayos, 35% para responder tareas, y más de uno de cada cinco admite haberla usado para redactar ensayos universitarios antes de pisar el campus. Como dice Roy Lee, ex estudiante de Columbia que usó ChatGPT para el 80% de sus ensayos: "La IA es simplemente parte del flujo de trabajo estudiantil ahora".

El contraste es fascinante: mientras algunos académicos alertan sobre la pérdida de habilidades críticas, los estudiantes en TikTok bromean sobre tener "85 cuentas de Google para más respuestas gratis". Un estudio del MIT encontró que los estudiantes que usaron ChatGPT mostraron menor actividad cerebral y se volvieron progresivamente más perezosos. La ironía es deliciosa: una generación que creció siendo evaluada por su capacidad de memorizar datos ahora tiene acceso instantáneo a todas las respuestas, pero quizás está perdiendo la capacidad de formular las preguntas correctas.

Reflexión: ¿Estamos presenciando el fin de la educación tal como la conocemos, o simplemente la evolución hacia algo que aún no sabemos definir? Como usar GPS hasta perder el sentido de orientación, pero aplicado al pensamiento.

✉️ ¿Crees que usar IA para estudiar es evolución natural o trampa peligrosa? Cuéntame tu experiencia con estudiantes o como estudiante.

IA y Regulación

La transformación de la “ambición” de los profesionales de la City.

Londres observa con inquietud cómo sus jóvenes financieros —los legendarios "tiburones" de la City— pierden el hambre de éxito que caracterizó a generaciones anteriores. El teletrabajo post-pandemia y la automatización por IA están transformando una cultura laboral que se construyó sobre presencia física, networking intensivo y competencia despiadada. Los veteranos del sector reportan que las nuevas generaciones priorizan el equilibrio vida-trabajo sobre los salarios astronómicos y las jornadas de 80 horas semanales.

Mientras tanto, algoritmos de trading cada vez más sofisticados están absorbiendo tareas que antes requerían intuición humana y análisis manual. La combinación resulta explosiva: menos ambición personal + más automatización = una transformación radical en el epicentro financiero global. Los headhunters confirman que encontrar candidatos dispuestos a sacrificar vida personal por rendimiento se ha vuelto una misión casi imposible.

Reflexión: Quizás estemos presenciando el fin de una era donde la productividad se medía en horas de oficina y la ambición en café consumido. Si la IA puede preparar el cierre procesar datos financieros mientras duermes, ¿para qué necesitas no dormir?

✉️ ¿Crees que el equilibrio vida-trabajo es incompatible con la excelencia profesional? Cuéntame tu experiencia.

La UE formaliza las reglas del juego: el AI Act cobra vida con su Código de Práctica

La Comisión Europea acaba de publicar el Código de Práctica bajo el AI Act, estableciendo las primeras reglas concretas y detalladas para los modelos de IA tipo GPT a nivel global. Este código voluntario, desarrollado con la participación de expertos del sector, exige transparencia operativa, medidas robustas de seguridad, protección rigurosa de derechos de autor y controles exhaustivos de riesgos para los grandes modelos de lenguaje. Lo que comienza como "voluntario" se convierte en obligatorio para los grandes operadores a partir del 2 de agosto de 2025, marcando un hito regulatorio sin precedentes.

El código representa el primer intento serio de traducir los principios abstractos del AI Act en requisitos operativos específicos. Las empresas deberán implementar sistemas de monitoreo, documentar procesos de entrenamiento, establecer mecanismos de auditoría y garantizar que sus modelos no infrinjan derechos de propiedad intelectual. La medida afecta directamente a gigantes como OpenAI, Google, Anthropic y Meta, quienes deberán demostrar cumplimiento o enfrentar sanciones que pueden alcanzar hasta el 7% de su facturación global anual.

Reflexión: Europa está apostando por convertirse en el "adult in the room" de la regulación de IA. ¿Será el modelo que copie el resto del mundo, o un freno burocrático que empuje la innovación hacia jurisdicciones más permisivas? La historia del GDPR sugiere lo primero.

✉️ ¿Crees que estas reglas europeas protegerán genuinamente a los usuarios o simplemente beneficiarán a las grandes tech que pueden permitirse el cumplimiento? ¿Deberían otros países adoptar marcos similares?

Estados Unidos. El mosaico regulatorio que nadie pidió: Estados vs. Administración Federal en la guerra de la IA

El panorama regulatorio de la IA se está fragmentando peligrosamente. La Cámara de Representantes de EE.UU. aprobó una moratoria de 10 años que bloquearía a los estados de regular la tecnología de IA, pero el Senado la eliminó del proyecto presupuestario que el presidente Trump firmó el 4 de julio Latest AI Breakthroughs and News: May, June, July 2025 | News. Esto significa que las empresas que usan herramientas impulsadas por IA en decisiones de personal deben navegar un pequeño pero creciente mosaico de regulaciones estatales y locales Latest AI Breakthroughs and News: May, June, July 2025 | News.

El resultado es preocupante: más de una docena de estados estadounidenses han aprobado o propuesto sus propias leyes de IA mientras la regulación federal se estanca, con leyes que varían ampliamente, cubriendo desde reconocimiento facial hasta herramientas automatizadas de contratación. Los expertos legales advierten que las leyes estatales conflictivas podrían crear dolores de cabeza de cumplimiento para las empresas. Mientras tanto, la ley de privacidad de datos de Minnesota que entra en vigor el 31 de julio requiere que las empresas permitan a los consumidores optar por no participar en el procesamiento automatizado de datos personales que influye en decisiones significativas Latest AI Breakthroughs and News: May, June, July 2025 | News.

Reflexión: Estados Unidos está creando un laberinto regulatorio donde las mismas tecnologías serán legales en un estado e ilegales en el siguiente. Como los primeros días de internet, pero con consecuencias mucho más serias para la Sociedad (y no solo la americana).

✉️ ¿Qué información específica del artículo del FT te parece más relevante para analizar? ¿Prefieres que enfoque en algún aspecto particular de la regulación de IA?

OneTrust abraza la ironía: usar IA para vigilar la IA

OneTrust acaba de lanzar su "Copilot" para automatización en cumplimiento de IA, una plataforma que usa Azure OpenAI para ayudar en investigaciones, evaluación de riesgos y cumplimiento regulatorio. La empresa, conocida por sus soluciones de privacidad y gobernanza, ahora apuesta por un asistente inteligente que promete fortalecer la gobernanza empresarial. El timing no podría ser más perfecto: mientras las regulaciones de IA se multiplican globalmente y las empresas luchan por entender qué significa "cumplimiento de IA", OneTrust ofrece una solución que es, esencialmente, IA supervisando IA.

La plataforma automatiza tareas tradicionalmente manuales como mapeo de riesgos, análisis de políticas y generación de reportes de cumplimiento. Es como contratar a un auditor que nunca se cansa, nunca se equivoca en las referencias normativas y puede procesar regulaciones cambiantes en tiempo real. La ironía es deliciosa: una herramienta de inteligencia artificial que te ayuda a cumplir con las reglas sobre... inteligencia artificial.

Reflexión: ¿Llegaremos al punto donde necesitemos IA para entender las reglas que nosotros mismos creamos para la IA? Como usar un traductor automático para leer las instrucciones de cómo usar traductores automáticos.

✉️ ¿Te parece sensata esta recursividad tecnológica o crees que estamos complicando innecesariamente la supervisión de algo que creamos nosotros? ¿Usarías IA para auditar tu propia IA?

IA en el mundo legal

IA legal con superpoderes: cuando ChatGPT conoce las leyes mejor que los abogados

Un nuevo paper publicado en arXiv explora cómo combinar IA Generativa Agéntica, potenciada por modelos de lenguaje grandes (LLMs) con Generación Aumentada por Recuperación (RAG), Grafos de Conocimiento (KGs) y Almacenes Vectoriales (VSs) [2502.20364] Bridging Legal Knowledge and AI: Retrieval-Augmented Generation with Vector Stores, Knowledge Graphs, and Hierarchical Non-negative Matrix Factorization para revolucionar la investigación jurídica. Los investigadores proponen un sistema que integra RAG, VS y KG, construido mediante Factorización de Matriz No Negativa (NMF), para mejorar la recuperación de información legal y el razonamiento de IA [2502.20364] Bridging Legal Knowledge and AI: Retrieval-Augmented Generation with Vector Stores, Knowledge Graphs, and Hierarchical Non-negative Matrix Factorization.

La idea es fascinante: el dominio legal comprende datos complejos caracterizados por sistemas de conocimiento extensos, interrelacionados y semiestructurados con relaciones complejas, incluyendo constituciones, estatutos, regulaciones y jurisprudencia [2502.20364] Bridging Legal Knowledge and AI: Retrieval-Augmented Generation with Vector Stores, Knowledge Graphs, and Hierarchical Non-negative Matrix Factorization. Imagina un ChatGPT que no solo entiende las leyes, sino que puede navegar las intrincadas redes de documentos legales y sus relaciones como un detective digital omnisciente. La tecnología sobresale en inferir relaciones dentro de vastos conjuntos de datos no estructurados o semiestructurados [2502.20364] Bridging Legal Knowledge and AI: Retrieval-Augmented Generation with Vector Stores, Knowledge Graphs, and Hierarchical Non-negative Matrix Factorization, lo que suena como el sueño dorado de cualquier bufete que factura por horas.

Reflexión: ¿Estamos viendo el nacimiento del primer asociado senior que nunca duerme, nunca se cansa y puede leer miles de casos en segundos? La ironía es que una profesión construida sobre la interpretación humana del lenguaje podría ser transformada por máquinas que procesan lenguaje mejor que nosotros.

✉️ ¿Crees que la IA hará la justicia más accesible o creará nuevas barreras entre quienes pueden pagarla y quienes no? ¿Confiarías en un abogado-robot para tu caso?

The LegalTech Fund acelera la presión sobre el modelo de negocio tradicional de las firmas legales con "Law Firm 2.0 Accelerator"

The LegalTech Fund ha lanzado "LegalTech Lab", un acelerador diseñado específicamente para construir el "Law Firm 2.0" —la próxima generación de proveedores de servicios legales que priorizan la IA sobre las estructuras tradicionales. La iniciativa surge en un momento explosivo para el sector: más de mil millones de dólares ya se han invertido en startups legaltech solo en 2025, y hasta Y Combinator ha incluido "Law Firm 2.0" en su lista de empresas objetivo.

El concepto es revolucionario: un bufete que es ágil, automatizado, asequible y enfocado en entregar una solución legal específica, no una amplia gama de áreas de práctica. Estas nuevas firmas apuntan a segmentos del mercado legal que los bufetes tradicionales han ignorado o excluido por precio, ofreciendo servicios hiperespecializados desde planificación patrimonial hasta contratos para startups. La filosofía central es clara: no reemplazar abogados, sino reemplazar las ineficiencias que existen dentro de los servicios legales.

El acelerador ya está viendo aplicaciones de empresas que abordan automatización de revisión de documentos, preparación de casos e incluso estrategia de litigio. Cada una está diseñada para "tallar una porción del mercado legal que las firmas tradicionales han ignorado o excluido por precio". Como señala la industria: "La IA legal permite que los abogados se enfoquen en trabajo de mayor valor, mientras que las nuevas startups ofrecen ayuda legal inteligente y rápida para todos los demás".

Reflexión: Estamos presenciando el momento Uber del derecho: la desagregación de servicios monolíticos en componentes especializados y tecnológicamente optimizados. Como si los bufetes tradicionales fueran blockbuster y Law Firm 2.0 fuera Netflix.

✉️ ¿Crees que este modelo "Law Firm 2.0" democratizará realmente el acceso a la justicia o simplemente creará una versión "premium vs. básica" de los servicios legales? ¿Preferirías un bufete automatizado y especializado o uno tradicional y generalista para tu próximo problema legal?

Escuela de Derecho del Universidad de San Francisco. Primera en integrar “en todo” el Programa la IA.

La Universidad de San Francisco acaba de lanzar un programa de derecho completamente integrado con inteligencia artificial, convirtiéndose en la primera facultad estadounidense en rediseñar su currículo entero alrededor de estas herramientas. Los estudiantes aprenderán desde primer año a usar IA para investigación legal, redacción de contratos y análisis de casos, mientras estudian las implicaciones éticas y regulatorias de la tecnología. El programa incluye materias como "Derecho y Algoritmos" y "Ética de la IA Legal", con acceso a plataformas especializadas como Harvey AI y LexisNexis+.

La apuesta es radical: formar abogados nativos digitales que dominen la IA como herramienta de trabajo, no como amenaza. Los críticos señalan el riesgo de formar profesionales dependientes de la tecnología, mientras los defensores argumentan que es la única forma de mantenerse relevantes en un mercado que cambia a velocidad de vértigo.

Reflexion: La ironía es llamativa: una profesión construida sobre precedentes centenarios ahora debe reinventarse cada seis meses. Entre formar juristas-cyborgs o quedarse con togas polvorientas, San Francisco eligió el futuro. El tiempo dirá si fue visión o vértigo.

✉️ ¿Qué piensas? Frente al suicidio de no hacer nada (útil), ¿Deberían las facultades de derecho apostar por la IA total o mantener el equilibrio tradicional? Responde y cuéntame tu experiencia.

"Ya probamos eso": cómo impulsar la innovación en las firmas legales “escépticas”

LexisNexis aborda una realidad incómoda en el sector legal: la fatiga del cambio y el escepticismo hacia la innovación en grandes bufetes. El fenómeno del "ya probamos eso" surge cuando iniciativas previas fracasaron no por la tecnología en sí, sino por timing inadecuado, implementación deficiente o estructuras de incentivos mal alineadas. La resistencia nace de fricciones fundamentales: mientras los abogados están impulsados por horas facturables, evitar riesgos y procesos legales precedentados, la innovación requiere experimentación, inversión de tiempo y a veces fracaso. Los obstáculos son sistemáticos: métricas de ROI demasiado estrechas que juzgan proyectos por ahorros de costos a corto plazo en lugar de impacto en retención de talento o satisfacción del cliente; adopción deficiente donde "probamos herramientas legales de IA antes y nadie las usó" debido a falta de entrenamiento o relevancia; y gobernanza adversa al riesgo que estanca esfuerzos bajo revisiones de diligencia debida o resistencia de socios.

La solución propuesta es comenzar con problemas, no productos: ¿Abogados gastando horas en investigación legal?

Reflexión: Los bufetes están atrapados en una paradoja: necesitan innovar para sobrevivir, pero su estructura básica de negocio (facturar por tiempo) desalienta la eficiencia que la tecnología promete. Como intentar adelgazar mientras trabajas en una pastelería.

✉️ ¿Crees que el problema fundamental es cultural o estructural? ¿Pueden los bufetes tradicionales realmente innovar sin cambiar su modelo de negocio basado en horas facturables?

Xapien: cuando la IA hace la DD en pocos minutos de detectar el dinero sucio

La startup británica Xapien acaba de cerrar una ronda de financiación de 10 millones de dólares para expandir su plataforma de due diligence impulsada por inteligencia artificial, dirigida específicamente a grandes firmas legales y bancos. La empresa se especializa en automatizar las investigaciones de compliance, un proceso tradicionalmente manual y laborioso que puede tomar días o semanas cuando se hace por humanos, pero que Xapien promete completar en minutos usando algoritmos avanzados.

La plataforma analiza múltiples fuentes de datos públicos y privados para identificar riesgos potenciales en clientes, contrapartes o inversiones, desde conexiones políticas hasta historiales criminales o sanciones internacionales. En un sector donde el costo del error puede medirse en multas de millones de dólares y daño reputacional irreversible, la propuesta de automatizar estas verificaciones resulta extremadamente atractiva para instituciones financieras y bufetes que manejan transacciones de alto valor.

El timing es perfecto: las regulaciones anti-lavado de dinero se han endurecido globalmente, mientras que la presión por acelerar transacciones sin comprometer el compliance crea una demanda insaciable de soluciones tecnológicas que puedan hacer ambas cosas simultáneamente.

Reflexión: ¿Estamos automatizando la detección de malos actores o creando nuevas formas de que los verdaderos expertos en elusión encuentren lagunas algorítmicas? La IA puede ser brillante detectando patrones conocidos, pero los criminales sofisticados siempre han sido maestros de la innovación.

✉️ ¿Confiarías en que una IA identifique completamente los riesgos de compliance de una transacción multimillonaria, o crees que ciertos juicios humanos son irreemplazables en este campo? ¿Dónde trazarías la línea entre eficiencia y prudencia?

IA & justicia

Cuando el juez cae en la trampa de la IA fantasiosa

Un tribunal de primera instancia en Georgia emitió una orden judicial basándose parcialmente en casos falsos creados por IA. En Shahid v. Esaam, el esposo citó dos casos inexistentes en su escrito sobre un divorcio, y el juez aceptó el argumento sin verificar las citas. Cuando la esposa apeló señalando que la orden era "nula de pleno derecho" por basarse en casos falsos, el esposo respondió citando 11 casos adicionales que también eran alucinaciones de IA o irrelevantes. El tribunal de apelación de Georgia sugirió que "las irregularidades en estos escritos sugieren que fueron redactados usando IA generativa" y citó el informe de 2023 del presidente del Tribunal Supremo John Roberts sobre los peligros de las "alucinaciones" de IA. El caso marca la primera vez que un juez emite una resolución basándose en jurisprudencia completamente inventada.

Reflexión: hemos pasado de abogados perezosos que citan casos falsos a jueces que los aprueban sin pestañear. Es como una cadena alimentaria de negligencia judicial donde la IA alimenta fantasías legales que los humanos consumen sin digerir. El esposo incluso pidió costas procesales basándose en un caso inventado: "una máquina de movimiento perpetuo de porquerías", como dice el artículo. La ironía suprema: después de décadas de criticar a los abogados por no leer las resoluciones, ahora ni los jueces las verifican.

✉️ ¿Qué piensas? ¿Es esto el principio del fin de la credibilidad del sistema judicial o simplemente el precio de aprender a convivir con la IA?

JUSTICE (www.justice.org.uk) publica el primer marco comprehensivo de IA para el sistema judicial

El informe "AI in our Justice System" de JUSTICE establece el primer marco comprehensivo para evaluar el uso de inteligencia artificial en el sistema judicial británico. El documento propone que cualquier innovación en el sistema judicial debe tener como propósito superior entregar un sistema judicial en el que la gente pueda confiar para sostener el estado de derecho y proteger los derechos humanos de todos.

El marco se construye sobre tres objetivos fundamentales:

acceso igual y efectivo a la justicia;

toma de decisiones justa y legal; y

escrutinio y participación pública.

JUSTICE argumenta que si la IA puede mejorar la capacidad de logro y función de estos objetivos, puede entregar un sistema judicial más fuerte. Sin embargo, si no mejora estos elementos, entonces el sistema judicial es menos capaz de sostener el estado de derecho, proteger derechos humanos y comandar la confianza de la sociedad.

El reporte establece dos requerimientos como salvaguardas: que los sistemas de IA deben tener un objetivo claro de mejorar uno o más de los objetivos fundamentales de un sistema judicial que funcione bien, y que todos los involucrados en el diseño, desarrollo y despliegue de IA dentro del sistema judicial tienen una responsabilidad de asegurar que las características centrales del estado de derecho y derechos humanos estén integradas en cada etapa.

Reflexión: Este marco podría convertirse en el estándar global para evaluar IA judicial. Como GPS para navegar el campo minado ético de automatizar la justicia, donde un error de dirección puede costar vidas y libertades.

✉️ ¿Crees que este marco de tres objetivos es suficientemente robust para evaluar todas las aplicaciones de IA en justicia, o faltan consideraciones críticas? ¿Debería ser adoptado por otros países?

Los tribunales estadounidenses: exhaustos pero escépticos de la IA

Una nueva encuesta del Thomson Reuters Institute revela una paradoja sorprendente en el sistema judicial estadounidense: aunque los tribunales enfrentan severas escaseces de personal y tensión operativa, permanecen renuentes a adoptar tecnologías de inteligencia artificial generativa que podrían proporcionar alivio significativo. Los números son contundentes: 68% de los tribunales reportaron escasez de personal y 48% de profesionales judiciales dicen que no tienen suficiente tiempo para completar su trabajo.

A pesar de estas presiones, solo 17% dice que su tribunal está usando IA generativa actualmente. La ironia es palpable: mientras 55% de los encuestados califican la IA como de impacto transformacional o alto en los tribunales durante los próximos cinco años, la adopción sigue siendo glacial. Los profesionales judiciales predicen que la IA generativa les ayudará a ahorrar un promedio de casi tres horas a la semana, elevándose a casi nueve horas a la semana dentro de cinco años.

Las barreras son claras: 70% de los encuestados dijeron que sus tribunales actualmente no permiten a los empleados usar herramientas basadas en IA para asuntos judiciales, y 75% dijeron que su tribunal aún no ha proporcionado entrenamiento en IA. David Slayton, del Tribunal Superior del Condado de Los Angeles, resume la urgencia: "Es responsabilidad de los líderes judiciales pensar realmente sobre cómo la tecnología puede ayudarnos con este problema".

Reflexión: Los tribunales están atrapados entre el miedo a la innovación y la realidad del colapso operativo. Como un conductor que se niega a usar GPS mientras está perdido en una tormenta, esperando que el mapa de papel lo salve.

✉️ ¿Crees que la resistencia judicial a la IA es prudencia institucional necesaria o miopía que perjudica el acceso a la justicia? ¿Deberían los tribunales ser forzados a modernizarse para servir mejor al público?

Lo volvemos a comentar.

La nueva Regla 707: cuando los tribunales necesitan detector de mentiras para la IA

La Judicial Conference de Estados Unidos está desarrollando la propuesta Regla Federal de Evidencia 707, una normativa pionera que establecería requisitos específicos de verificación para información generada por inteligencia artificial en los tribunales federales. Esta regla responde a una necesidad crítica: distinguir entre evidencia auténtica y contenido sintético en una era donde la IA puede crear textos, imágenes, videos y audio prácticamente indistinguibles de los originales.

La propuesta surge de la urgente necesidad de proteger la integridad del sistema judicial ante el aumento exponencial de evidencia generada por IA. Los tribunales enfrentan desafíos sin precedentes: desde documentos fabricados por ChatGPT hasta deepfakes de video que podrían alterar testimonios, pasando por fotografías sintéticas que nunca ocurrieron pero parecen completamente reales. La Regla 707 exigiría que las partes revelen cuando la evidencia presentada ha sido generada o modificada por IA, estableciendo protocolos de autenticación y cadenas de custodia específicas para contenido sintético.

La medida representa un cambio fundamental en el derecho probatorio estadounidense, reconociendo que las reglas tradicionales de evidencia no fueron diseñadas para una era donde las máquinas pueden crear "hechos" convincentes de la nada.

Reflexión: stamos presenciando el nacimiento de una nueva era judicial donde "mostrar evidencia" ya no significa "esto pasó" sino "esto es auténtico". Como si cada tribunal necesitara su propio departamento de efectos especiales forenses.

¿Podemos plantear un protocolo equivalente en España?

✉️ ¿Crees que es posible crear reglas efectivas para detectar evidencia de IA, o siempre iremos un paso atrás de la tecnología? ¿Deberían todas las evidencias digitales considerarse sospechosas por defecto? ¿Qué protocólo propondrías?

Un Estado U.S. establece la hoja de ruta: tres años para domesticar la IA judicial

El Comité Ad Hoc del Consejo Judicial de Georgia sobre Inteligencia Artificial y los Tribunales ha presentado su informe tras una revisión de 10 meses iniciada en agosto de 2024. Bajo el liderazgo del Juez Andrew A. Pinson, el comité propone un ambicioso plan de tres años para integrar la IA en el sistema judicial de Georgia, que comenzará con el establecimiento de liderazgo y gobernanza y concluirá con nuevas políticas para todos los tribunales del estado.

El informe "Artificial Intelligence and Georgia's Courts" establece una taxonomía clara: usos aceptables como investigación y programación, usos inaceptables como selección de jurados y algoritmos de sentencia "caja negra", y usos potenciales que necesitan más estudio como traducción de idiomas y evaluaciones de riesgo. Durante su revisión, el comité documentó ejemplos variados: desde el uso de IA de Indiana para transcripciones voz-a-texto, hasta los avatares de IA de Arizona para anunciar fallos judiciales, e incluso el uso de una familia de IA para crear una declaración de impacto de víctima por su pariente fallecido.

La iniciativa surge después de casos problemáticos donde abogados han usado IA para citar casos ficticios, causando que los jueces adviertan sobre las "alucinaciones" de la IA que pueden privar a las partes contrarias de la oportunidad de responder apropiadamente.

Reflexión: Georgia está escribiendo el manual que otros estados copiarán. Su enfoque gradual sugiere que entienden algo crucial: la justicia no puede permitirse experimentos fallidos, pero tampoco puede ignorar las herramientas que podrían hacerla más eficiente y accesible.

✉️ ¿Te parece sensato este enfoque de tres años o crees que la IA evoluciona demasiado rápido para planes tan largos? ¿Qué otros usos "inaceptables" agregarías a la lista de Georgia?